- 收藏

- 点赞

- 分享

- 举报

SD3403/SS928 NPU算子ResizeBilinearV2执行结果异常

问题描述:

我在使用pytorch架构的bisenet模型,转换为ONNX后再转换成om模型运行结果异常,随后定位到问题出现在模型最后的上采样算子ResizeBilinearV2。

在pytorch中使用F.interpolate或nn.Upsample,使用ATC转换后都会变成CANN的ResizeBilinearV2算子

F.interpolate(x, scale_factor=2, mode='bilinear', align_corners=False)

nn.Upsample(scale_factor=2, mode='bilinear', align_corners=False)

为了测试,使用了一个只有F.interpolate的onnx模型:

```python

class ResizeModel(torch.nn.Module):

def __init__(self, scale_factor=2.0):

super(ResizeModel, self).__init__()

self.scale_factor = scale_factor

def forward(self, x):

# 仅执行 Resize 操作

return F.interpolate(x, scale_factor=self.scale_factor, mode='bilinear', align_corners=False)

```

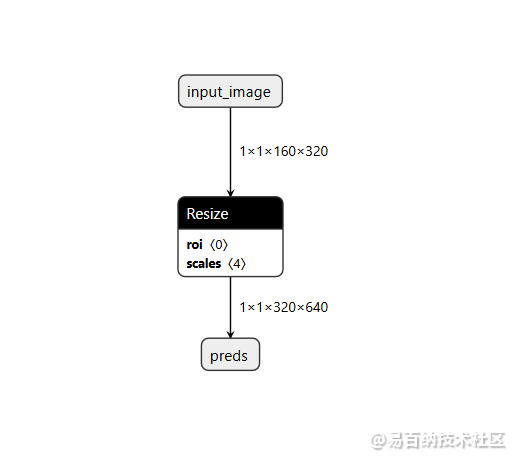

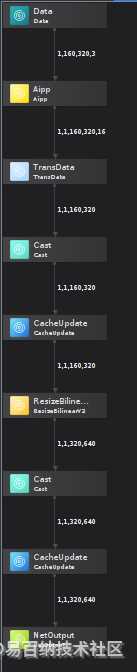

onnx模型如图

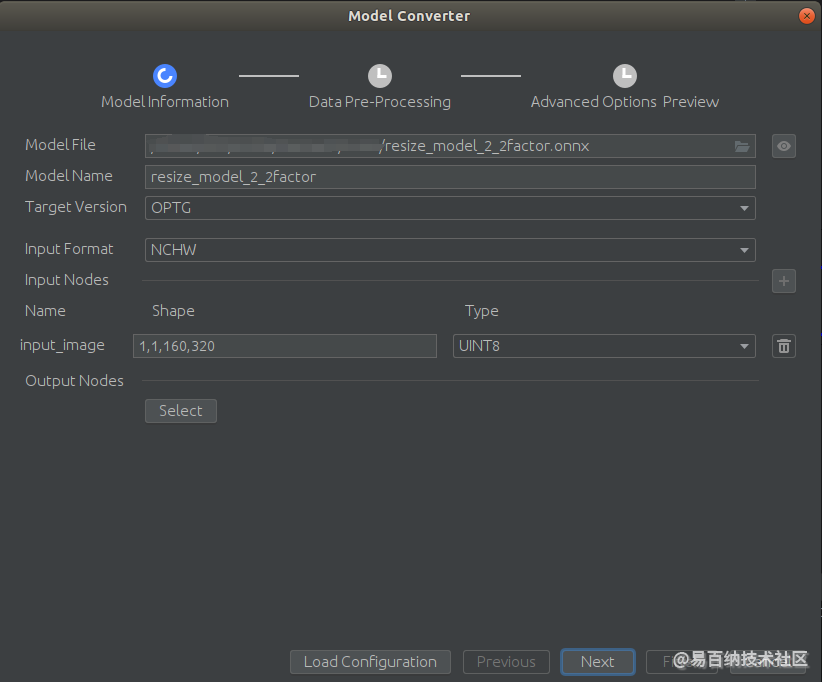

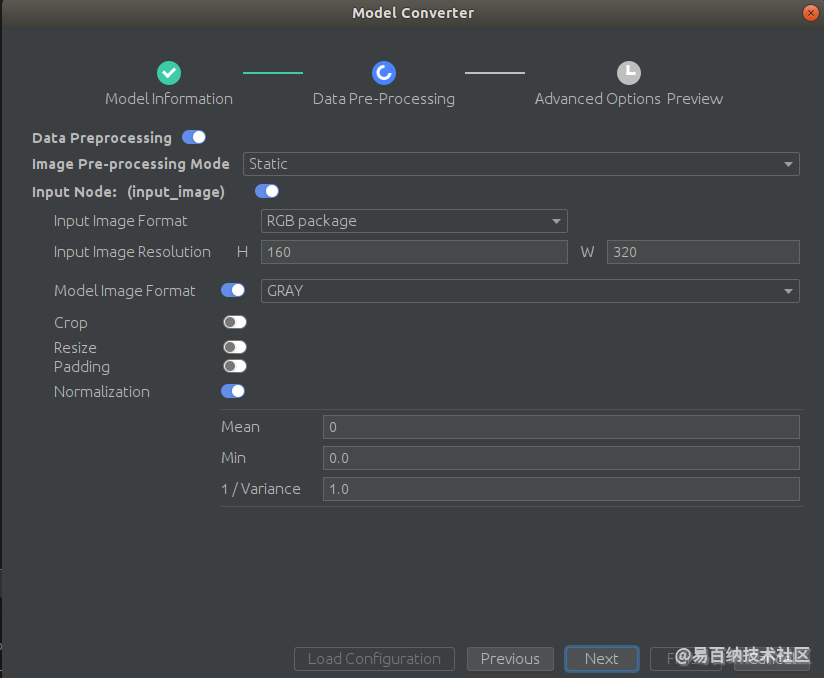

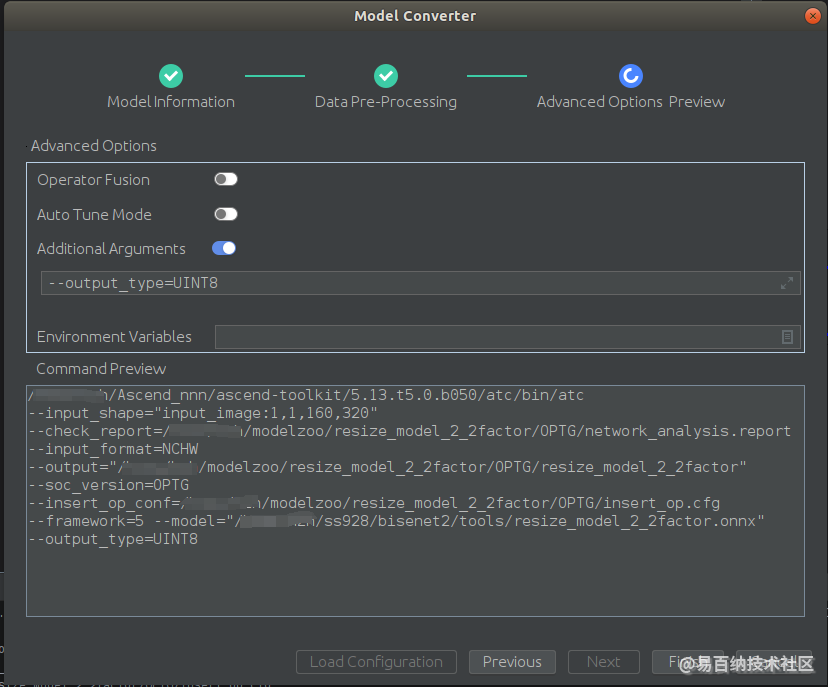

使用MindStudio进行ATC模型转换:

aipp_op {

related_input_rank : 0

src_image_size_w : 320

src_image_size_h : 160

crop : false

resize : false

padding : false

input_format : RGB888_U8

aipp_mode: static

csc_switch : true

rbuv_swap_switch : true

matrix_r0c0 : 76

matrix_r0c1 : 150

matrix_r0c2 : 30

matrix_r1c0 : 0

matrix_r1c1 : 0

matrix_r1c2 : 0

matrix_r2c0 : 0

matrix_r2c1 : 0

matrix_r2c2 : 0

input_bias_0 : 0

input_bias_1 : 0

input_bias_2 : 0

mean_chn_0 : 0

min_chn_0 : 0.0

var_reci_chn_0 : 1.0

}

2024-12-06 09:35:10 Start to convert model

2024-12-06 09:35:10 export PATH=$PATH:/home/hzh/Ascend_nnn/ascend-toolkit/5.13.t5.0.b050/atc/ccec_compiler/bin:/home/hzh/Ascend_nnn/ascend-toolkit/5.13.t5.0.b050/atc/bin && export PYTHONPATH=$PYTHONPATH:/home/hzh/Ascend_nnn/ascend-toolkit/5.13.t5.0.b050/atc/python/site-packages:/home/hzh/Ascend_nnn/ascend-toolkit/5.13.t5.0.b050/atc/python/site-packages/auto_tune.egg/auto_tune:/home/hzh/Ascend_nnn/ascend-toolkit/5.13.t5.0.b050/atc/python/site-packages/schedule_search.egg && export LD_LIBRARY_PATH=/home/hzh/Ascend_nnn/ascend-toolkit/5.13.t5.0.b050/atc/lib64:/home/hzh/Ascend_nnn/ascend-toolkit/5.13.t5.0.b050/toolkit/lib64:/home/hzh/Ascend_nnn/ascend-toolkit/5.13.t5.0.b050/add-ons:$LD_LIBRARY_PATH:/home/hzh/Ascend_nnn/ascend-toolkit/5.13.t5.0.b050/atc/lib64/stub && export SLOG_PRINT_TO_STDOUT=1 && export ASCEND_OPP_PATH=/home/hzh/Ascend_nnn/ascend-toolkit/5.13.t5.0.b050/opp && /home/hzh/Ascend_nnn/ascend-toolkit/5.13.t5.0.b050/atc/bin/atc --input_shape="input_image:1,1,160,320" --check_report=/home/hzh/modelzoo/resize_model_2_2factor/OPTG/network_analysis.report --input_format=NCHW --output="/home/hzh/modelzoo/resize_model_2_2factor/OPTG/resize_model_2_2factor" --soc_version=OPTG --insert_op_conf=/home/hzh/modelzoo/resize_model_2_2factor/OPTG/insert_op.cfg --framework=5 --model="/home/hzh/ss928/bisenet2/tools/resize_model_2_2factor.onnx" --output_type=UINT8

2024-12-06 09:35:10 ATC start working now, please wait for a moment.

2024-12-06 09:35:38 ATC run success, welcome to the next use.

2024-12-06 09:35:38 W11001: Op [trans_Cast_2] does not hit the high-priority operator information library, which might result in compromised performance.

2024-12-06 09:35:38 Convert model environment variables:

2024-12-06 09:35:38 export PATH=$PATH:/home/hzh/Ascend_nnn/ascend-toolkit/5.13.t5.0.b050/atc/ccec_compiler/bin:/home/hzh/Ascend_nnn/ascend-toolkit/5.13.t5.0.b050/atc/bin && export PYTHONPATH=$PYTHONPATH:/home/hzh/Ascend_nnn/ascend-toolkit/5.13.t5.0.b050/atc/python/site-packages:/home/hzh/Ascend_nnn/ascend-toolkit/5.13.t5.0.b050/atc/python/site-packages/auto_tune.egg/auto_tune:/home/hzh/Ascend_nnn/ascend-toolkit/5.13.t5.0.b050/atc/python/site-packages/schedule_search.egg && export LD_LIBRARY_PATH=/home/hzh/Ascend_nnn/ascend-toolkit/5.13.t5.0.b050/atc/lib64:/home/hzh/Ascend_nnn/ascend-toolkit/5.13.t5.0.b050/toolkit/lib64:/home/hzh/Ascend_nnn/ascend-toolkit/5.13.t5.0.b050/add-ons:$LD_LIBRARY_PATH:/home/hzh/Ascend_nnn/ascend-toolkit/5.13.t5.0.b050/atc/lib64/stub && export SLOG_PRINT_TO_STDOUT=1 && export ASCEND_OPP_PATH=/home/hzh/Ascend_nnn/ascend-toolkit/5.13.t5.0.b050/opp

2024-12-06 09:35:38 Convert model command:

2024-12-06 09:35:38 /home/hzh/Ascend_nnn/ascend-toolkit/5.13.t5.0.b050/atc/bin/atc --input_shape="input_image:1,1,160,320" --check_report=/home/hzh/modelzoo/resize_model_2_2factor/OPTG/network_analysis.report --input_format=NCHW --output="/home/hzh/modelzoo/resize_model_2_2factor/OPTG/resize_model_2_2factor" --soc_version=OPTG --insert_op_conf=/home/hzh/modelzoo/resize_model_2_2factor/OPTG/insert_op.cfg --framework=5 --model="/home/hzh/ss928/bisenet2/tools/resize_model_2_2factor.onnx" --output_type=UINT8

2024-12-06 09:35:38 Model converted successfully.

2024-12-06 09:35:38 Model input path:/home/hzh/ss928/bisenet2/tools/resize_model_2_2factor.onnx

2024-12-06 09:35:38 Model output path:/home/hzh/modelzoo/resize_model_2_2factor/OPTG

2024-12-06 09:35:38 Aipp config file path:/home/hzh/modelzoo/resize_model_2_2factor/OPTG/insert_op.cfg

2024-12-06 09:35:38 Model conversion log file path:/home/hzh/modelzoo/resize_model_2_2factor/OPTG/ModelConvert.txt

2024-12-06 09:35:38 Model conversion config file path:/home/hzh/modelzoo/resize_model_2_2factor/OPTG/resize_model_2_2factor_config.json

转换过程没有报错,其中[W11001:]是一个FP32转换UINT8类型的警告

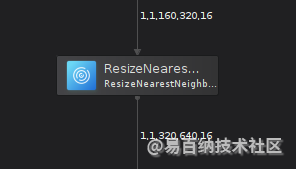

转换后的om模型如下:

模型输入为RGB_U8_Packed类型的二进制图像,通过AIPP转换为Gray灰度图像,然后使用ResizeBilinearV2进行插值放大,输出插值放大后的U8灰度图像

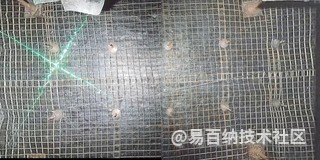

以下为测试用输入图像

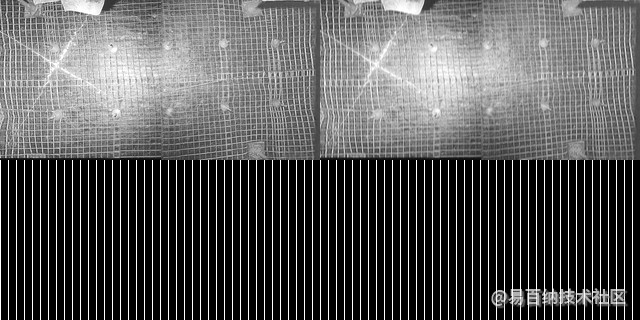

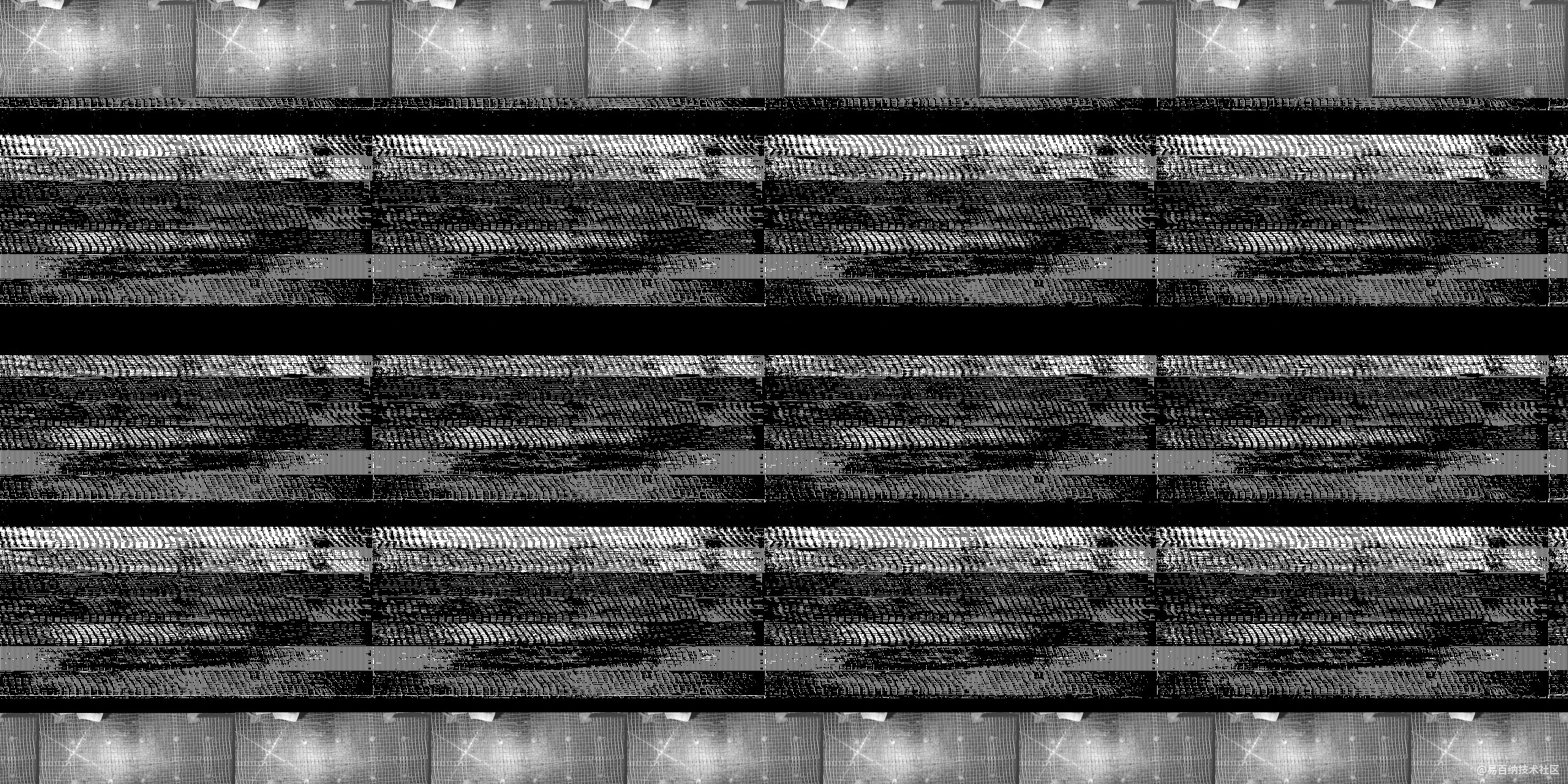

使用om模型在3403板端推理结果:

scale_factor=2

scale_factor=8

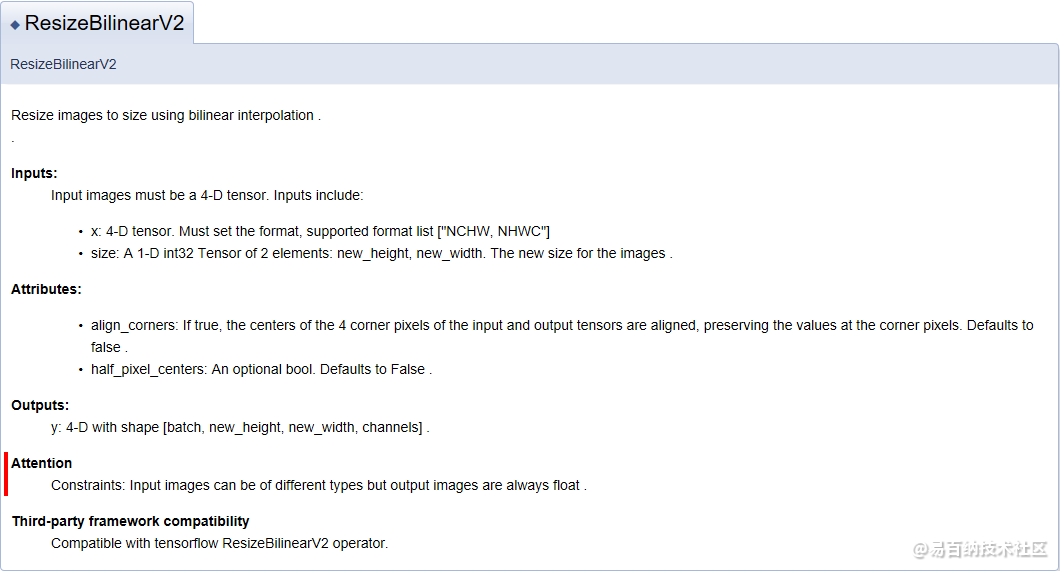

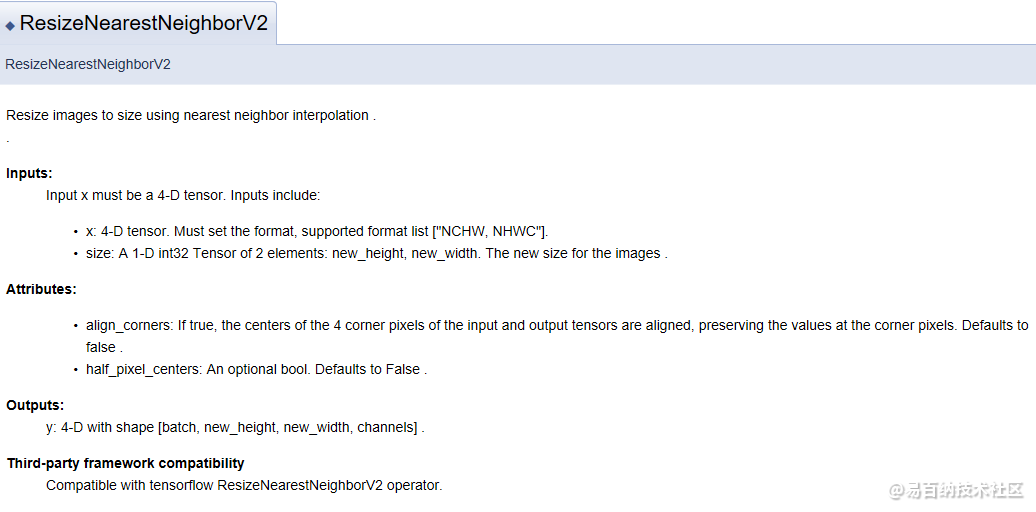

这种情况是什么原因?是需要做后处理?还是ResizeBilinearV2算子不支持,但我在《CANN算子规格说明》中找到了ResizeBilinearV2这个算子说明

ATC版本:5.13.t5.0.B050

SDK版本:V2.0.2.1

~~~~

还有一个问题,当我尝试使用nearest插值代替bilinear的时候发现,如果直接使用nearest放大8倍,

nn.Upsample(scale_factor=8),

# nn.Upsample(scale_factor=8, mode='bilinear', align_corners=False)

ATC转换会报错,但可以产生om模型,且运行会报错:

2024-12-06 10:14:18 ModuleNotFoundError: No module named 'impl.resize_nearest_neighbor_v2'

2024-12-06 10:14:18 ModuleNotFoundError: No module named 'impl.resize_nearest_neighbor_v2'

2024-12-06 10:14:18 ATC run success, welcome to the next use.

2024-12-06 10:14:18 W11001: Op [PartitionedCall_ResizeNearestNeighborV2_81_31] does not hit the high-priority operator information library, which might result in compromised performance.

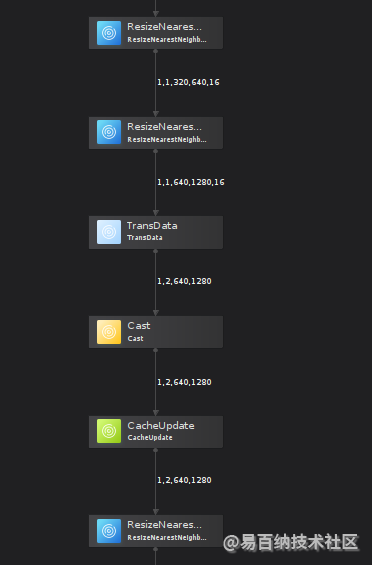

如果放大2倍则可以正常转换而且可以正常运行,使用的算子为ResizeNearestNeighborV2,且输入输出为NC1HWC0类型

nn.Upsample(scale_factor=2),

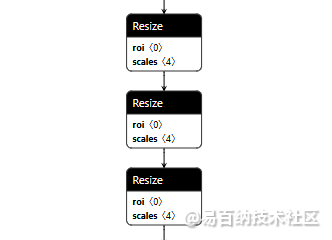

但如果使用连续三次nearest插值放大2倍,从而放大8倍时,转换就会报错,但可以产生om模型,且运行会报错

nn.Upsample(scale_factor=2),

nn.Upsample(scale_factor=2),

nn.Upsample(scale_factor=2)

2024-12-06 10:35:47 ModuleNotFoundError: No module named 'impl.resize_nearest_neighbor_v2'

2024-12-06 10:35:47 ModuleNotFoundError: No module named 'impl.resize_nearest_neighbor_v2'

2024-12-06 10:35:47 ATC run success, welcome to the next use.

2024-12-06 10:35:47 W11001: Op [PartitionedCall_ResizeNearestNeighborV2_106_62] does not hit the high-priority operator information library, which might result in compromised performance.

而且3次连续的resize在om模型中被分为两部分,前两次数据类型为NC1HWC0,而第三期resize前先做了数据类型转换,由NC1HWC0转换为了NCHW。而且ATC转换报错的正是使用NCHW格式的那个算子,而前两个使用NC1HWC0的则显示正常,这是什么原因?和缩放数据的尺寸有关系么?

在《CANN算子规格说明》中,ResizeNearestNeighborV2支持NCHW格式,没有提到NC1HWC0

文件: resize_model.onnx

文件: resize_model.onnx

文件: resize_model.om

文件: resize_model.om

文件: rgbu8_img.bin

文件: rgbu8_img.bin

Markdown 语法

- 加粗**内容**

- 斜体*内容*

- 删除线~~内容~~

- 引用> 引用内容

- 代码`代码`

- 代码块```编程语言↵代码```

- 链接[链接标题](url)

- 无序列表- 内容

- 有序列表1. 内容

- 缩进内容

- 图片

-

2023-06-12 15:59:49

-

2024-08-28 14:17:53

-

2023-06-12 16:01:52

-

2025-06-13 15:27:29

-

2024-12-31 18:04:08

-

2025-07-29 13:55:07

-

2025-08-05 09:47:37

-

2023-04-11 17:01:30

-

2024-12-12 11:57:32

-

2025-03-20 11:47:23

-

2025-06-16 17:40:49

-

2025-01-07 10:49:33

-

2025-06-12 10:32:18

-

2023-06-12 15:57:38

-

2025-02-27 15:31:19

-

2025-08-19 18:35:57

-

2024-03-19 17:20:28

-

2023-06-12 15:49:46

-

2024-02-19 14:27:37

-

100hi3516cv610 通过易百纳官方SDK中编译出的uboot env kernel,移植到自己的工程中,MPP初始化时出现内核拷贝数据到用户端时出现错误导致内核进入pain模式进而时内核重启

-

5hisi3519 gs2972 bt1120 转sdi 无法正常显示问题

-

5hisi3516cv610 + gc4336p 夜晚很模糊

-

5AIISP(功能演示,SC4336P为BGGR,强制转RGGB,会导致颜色异常)

-

5rv1106使用luckfox的SDK,设备树和驱动都写好了,结果设备文件没有生成

-

5海思3516cv610中如何进行SD卡升级,根据官方文档操作,烧录进板子时,走的默认uboot,没有执行uboot升级。

-

5G610Q-IPC-38E 夜晚很暗 有什么办法解决吗 已经补光了

-

10转换模型时,SoC版本里没显示hi3516cv610芯片

-

5hisi3516cv610 使用 yolov8n 模型训练 要如何提高 这里识别的是人

-

10有人在海思平台接过SC035HGS吗

举报类型

- 内容涉黄/赌/毒

- 内容侵权/抄袭

- 政治相关

- 涉嫌广告

- 侮辱谩骂

- 其他

详细说明

微信扫码分享

微信扫码分享 QQ好友

QQ好友