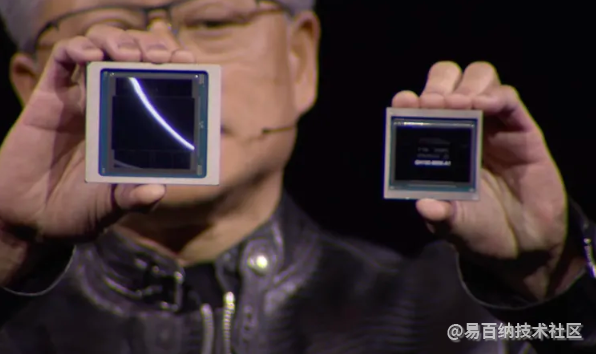

英伟达公布Blackwell B200 GPU,“世界上最 强大的人工智能芯片”

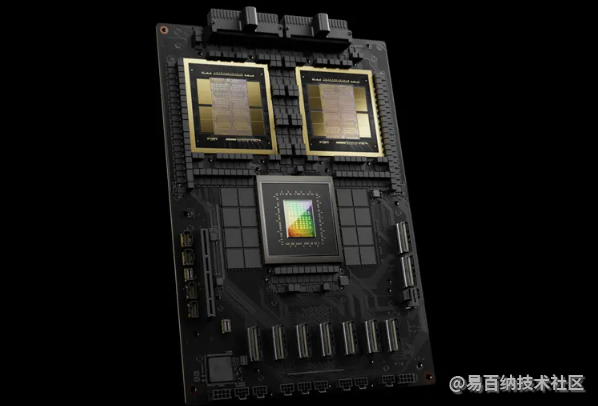

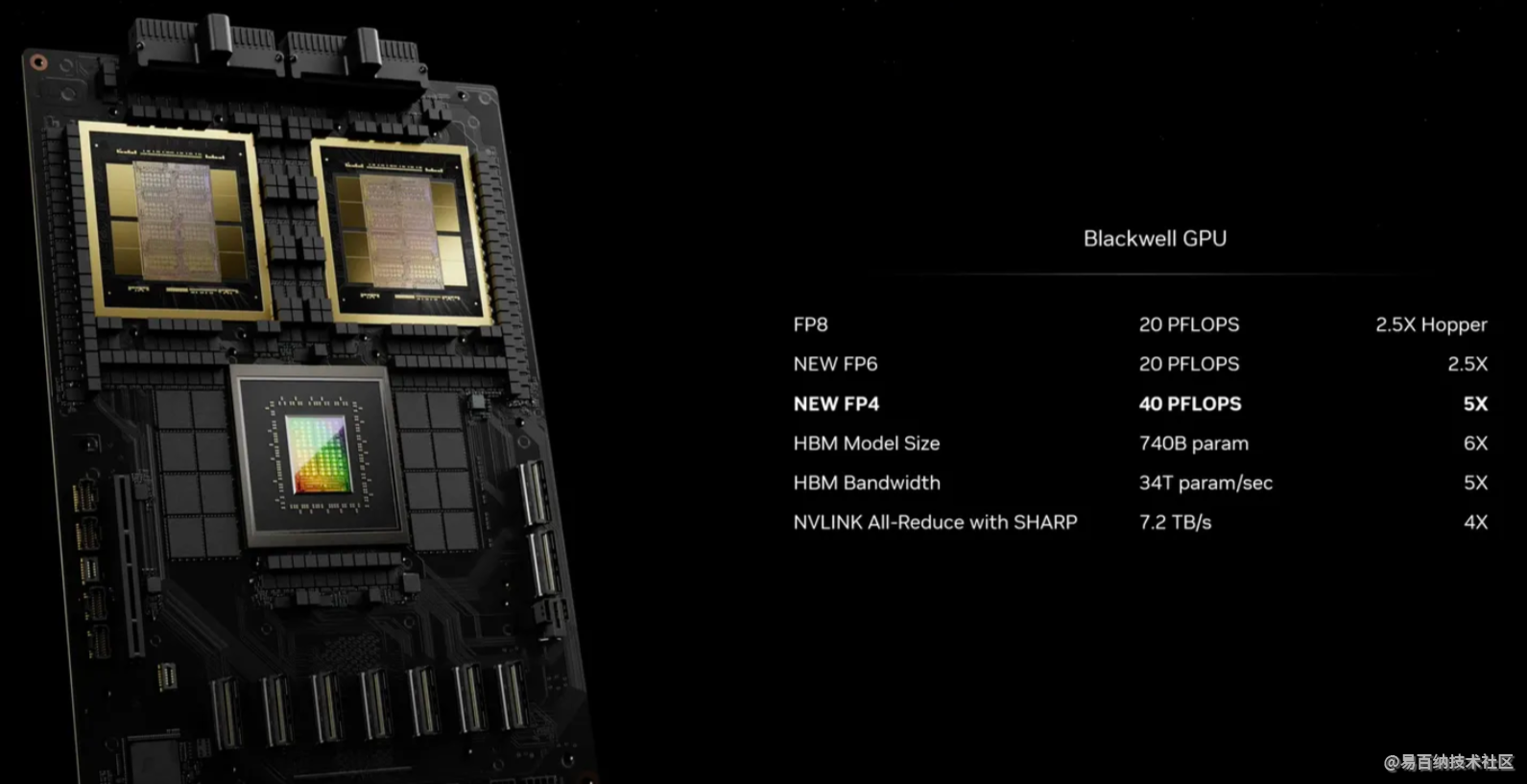

英伟达表示,新的B200 GPU通过其2080亿个晶体管提供了高达20 petaflops的FP4马力。此外,它还表示,将其中两个GPU与一个Grace CPU相结合的GB200可以为LLM推理工作负载提供30倍的性能,同时也可能大大提高效率。英伟达表示,它比H100“降低了高达25倍的成本和能耗”。

英伟达称,之前训练一个1.8万亿参数的模型需要8000个Hopper gpu和15兆瓦的功率。今天,英伟达的首席执行官表示,2000个Blackwell gpu可以在消耗4兆瓦的情况下完成这一任务。

在拥有1750亿个参数的GPT-3 LLM基准测试中,英伟达表示,GB200的性能是H100的7倍,训练速度是H100的4倍。

英伟达告诉记者,关键的改进之一是第二代变压器引擎,通过每个神经元使用4位而不是8位,使计算、带宽和模型大小翻了一番(我之前提到的FP4每秒20千万亿次浮点运算)。第二个关键的区别是当你把大量的gpu连接在一起时:下一代NVLink交换机可以让576个gpu相互通信,每秒1.8 tb的双向带宽。

这需要英伟达打造一个全新的网络交换芯片,其中包含500亿个晶体管和一些自己的板载计算:每秒3.6万亿次浮点运算的FP8,英伟达说。

此前,英伟达表示,一个只有16个gpu的集群将花费60%的时间用于相互通信,只有40%的时间用于实际计算。

当然,英伟达希望公司大量购买这些gpu,并将它们封装在更大的设计中,比如GB200 NVL72,它将36个cpu和72个gpu插入到一个液冷机架中,总共可以实现每秒720千万亿次的人工智能训练性能或每秒1440千万亿次的推理性能。它内部有近两英里长的电缆,有5000条单独的电缆。

机架中的每个托盘包含两个GB200芯片或两个NVLink交换机,每个机架有18个GB200芯片和9个NVLink交换机。英伟达表示,其中一个机架可以支持27万亿参数模型。传闻GPT-4是一个约1.7万亿参数模型。

该公司表示,亚马逊(Amazon)、谷歌、微软(Microsoft)和Oracle都已经计划在其云服务产品中提供NVL72机架,但尚不清楚他们打算购买多少。

当然,英伟达也很乐意为企业提供其余的解决方案。这是DGX GB200的DGX Superpod,它将八个系统结合在一起,总共有288个cpu, 576个gpu, 240TB内存和11.5 exaflops的FP4计算。

英伟达表示,其系统可以扩展到数以万计的GB200超级芯片,通过其新的Quantum-X800 InfiniBand(最多144个连接)或Spectrum-X800以太网(最多64个连接)连接在一起,形成800Gbps的网络。

- 分享

- 举报

暂无数据

暂无数据-

浏览量:2813次2018-01-18 17:45:43

-

浏览量:532次2023-09-16 10:51:37

-

浏览量:2120次2018-12-25 18:54:12

-

浏览量:2707次2019-01-13 17:23:26

-

浏览量:1339次2022-12-06 19:29:47

-

浏览量:493次2023-10-18 16:49:04

-

浏览量:2561次2018-02-28 22:15:06

-

浏览量:2189次2020-06-28 18:42:37

-

浏览量:3357次2022-03-23 11:51:06

-

浏览量:2027次2020-06-09 10:26:53

-

浏览量:727次2023-08-04 10:24:56

-

浏览量:2374次2019-01-29 20:16:55

-

浏览量:906次2023-08-25 09:54:29

-

浏览量:1922次2018-04-01 21:55:54

-

浏览量:4398次2017-11-02 17:07:21

-

浏览量:1922次2018-06-07 13:01:57

-

浏览量:2358次2018-03-29 16:57:07

-

浏览量:2120次2018-02-11 20:12:30

-

浏览量:3075次2020-12-10 10:53:29

-

广告/SPAM

-

恶意灌水

-

违规内容

-

文不对题

-

重复发帖

tomato

微信支付

微信支付举报类型

- 内容涉黄/赌/毒

- 内容侵权/抄袭

- 政治相关

- 涉嫌广告

- 侮辱谩骂

- 其他

详细说明

微信扫码分享

微信扫码分享 QQ好友

QQ好友