技术专栏

一个神奇的算法,ID3!!

大家好,今天来聊聊决策树中的ID3算法!

ID3(Iterative Dichotomiser 3)是一种经典的决策树学习算法,用于从训练数据中构建决策树模型。

基本原理

ID3算法基于信息增益来选择最 佳的划分属性。它通过计算每个属性对目标变量的信息增益,并选择具有最高信息增益的属性作为当前节点的划分属性。然后,它递归地应用相同的过程来构建子树,直到达到以下任一条件:

- 所有的实例都属于同一类别,即叶节点纯净。

- 没有更多的属性可用于进一步划分,但仍存在多个类别的实例。在这种情况下,选择出现频率最高的类别作为叶节点的类别。

优点

- 简单易懂,容易解释和可视化。

- 能够处理非数值型特征。

- 可以处理缺失值。

- 生成的决策树可以用于分类和预测。

缺点

- ID3算法倾向于选择具有较多取值的属性作为划分属性,导致生成的决策树深度较大,容易过拟合。

- 对于连续型特征,ID3算法需要进行离散化处理。

- 对于包含许多属性的数据集,ID3算法可能会面临组合爆炸的问题。

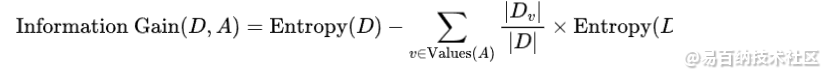

在ID3算法中,使用了信息增益(Information Gain)来衡量每个属性对目标变量的重要性。信息增益的公式如下:

其中:

- D是当前节点的训练样本集合;

- A是属性集合中的一个属性;

是属性A的取值集合;

是属性A的取值集合; 是样本集合D中属性A取值为v的样本子集;

是样本集合D中属性A取值为v的样本子集; 是样本集合D的熵。

是样本集合D的熵。

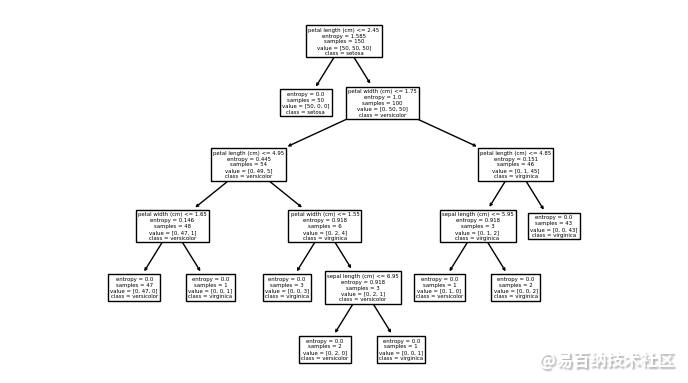

用一个Python案例说明

以下是一个使用Python实现ID3算法并绘制决策树的简单示例:

import numpy as np

from sklearn.datasets import load_iris

from sklearn.tree import DecisionTreeClassifier, plot_tree

# 加载鸢尾花数据集

data = load_iris()

X = data.data

y = data.target

# 使用ID3算法构建决策树模型

model = DecisionTreeClassifier(criterion='entropy')

model.fit(X, y)

# 可视化决策树

plot_tree(model, feature_names=data.feature_names, class_names=data.target_names)- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

运行这段代码将绘制出一个决策树的图像,其中节点表示属性划分,叶节点表示类别。你可以使用这个图像来理解决策树是如何进行分类的。

[Text(0.5, 0.9166666666666666, 'petal length (cm) <= 2.45\nentropy = 1.585\nsamples = 150\nvalue = [50, 50, 50]\nclass = setosa'),

Text(0.4230769230769231, 0.75, 'entropy = 0.0\nsamples = 50\nvalue = [50, 0, 0]\nclass = setosa'),

Text(0.5769230769230769, 0.75, 'petal width (cm) <= 1.75\nentropy = 1.0\nsamples = 100\nvalue = [0, 50, 50]\nclass = versicolor'),

Text(0.3076923076923077, 0.5833333333333334, 'petal length (cm) <= 4.95\nentropy = 0.445\nsamples = 54\nvalue = [0, 49, 5]\nclass = versicolor'),

Text(0.15384615384615385, 0.4166666666666667, 'petal width (cm) <= 1.65\nentropy = 0.146\nsamples = 48\nvalue = [0, 47, 1]\nclass = versicolor'),

Text(0.07692307692307693, 0.25, 'entropy = 0.0\nsamples = 47\nvalue = [0, 47, 0]\nclass = versicolor'),

Text(0.23076923076923078, 0.25, 'entropy = 0.0\nsamples = 1\nvalue = [0, 0, 1]\nclass = virginica'),

Text(0.46153846153846156, 0.4166666666666667, 'petal width (cm) <= 1.55\nentropy = 0.918\nsamples = 6\nvalue = [0, 2, 4]\nclass = virginica'),

Text(0.38461538461538464, 0.25, 'entropy = 0.0\nsamples = 3\nvalue = [0, 0, 3]\nclass = virginica'),

Text(0.5384615384615384, 0.25, 'sepal length (cm) <= 6.95\nentropy = 0.918\nsamples = 3\nvalue = [0, 2, 1]\nclass = versicolor'),

Text(0.46153846153846156, 0.08333333333333333, 'entropy = 0.0\nsamples = 2\nvalue = [0, 2, 0]\nclass = versicolor'),

Text(0.6153846153846154, 0.08333333333333333, 'entropy = 0.0\nsamples = 1\nvalue = [0, 0, 1]\nclass = virginica'),

Text(0.8461538461538461, 0.5833333333333334, 'petal length (cm) <= 4.85\nentropy = 0.151\nsamples = 46\nvalue = [0, 1, 45]\nclass = virginica'),

Text(0.7692307692307693, 0.4166666666666667, 'sepal length (cm) <= 5.95\nentropy = 0.918\nsamples = 3\nvalue = [0, 1, 2]\nclass = virginica'),

Text(0.6923076923076923, 0.25, 'entropy = 0.0\nsamples = 1\nvalue = [0, 1, 0]\nclass = versicolor'),

Text(0.8461538461538461, 0.25, 'entropy = 0.0\nsamples = 2\nvalue = [0, 0, 2]\nclass = virginica'),

Text(0.9230769230769231, 0.4166666666666667, 'entropy = 0.0\nsamples = 43\nvalue = [0, 0, 43]\nclass = virginica')]- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

<

请注意,以上示例中使用了scikit-learn库的DecisionTreeClassifier来实现ID3算法,并且调用了plot_tree函数来绘制决策树。

声明:本文内容由易百纳平台入驻作者撰写,文章观点仅代表作者本人,不代表易百纳立场。如有内容侵权或者其他问题,请联系本站进行删除。

红包

点赞

收藏

评论

打赏

- 分享

- 举报

评论

0个

手气红包

暂无数据

暂无数据相关专栏

-

浏览量:943次2023-10-25 18:39:50

-

浏览量:2356次2022-03-22 09:00:12

-

浏览量:107次2025-03-05 14:40:45

-

浏览量:6145次2022-05-09 11:00:58

-

浏览量:6781次2022-05-30 15:26:15

-

浏览量:4421次2021-08-26 14:50:36

-

2023-02-15 10:31:45

-

浏览量:2189次2020-08-14 18:15:32

-

浏览量:190次2025-03-08 11:24:40

-

浏览量:5829次2021-08-04 13:46:28

-

浏览量:2155次2018-12-19 12:36:45

-

浏览量:14135次2020-12-09 09:53:36

-

浏览量:2534次2020-09-30 18:11:55

-

浏览量:2126次2019-05-31 15:30:46

-

浏览量:9124次2021-08-09 15:05:08

-

浏览量:2837次2020-10-13 11:47:39

-

浏览量:1813次2020-01-02 10:02:34

-

浏览量:3796次2020-12-24 10:27:37

-

浏览量:738次2024-02-19 11:36:31

置顶时间设置

结束时间

删除原因

-

广告/SPAM

-

恶意灌水

-

违规内容

-

文不对题

-

重复发帖

打赏作者

Ocean

您的支持将鼓励我继续创作!

打赏金额:

¥1

¥5

¥10

¥50

¥100

支付方式:

微信支付

微信支付

举报反馈

举报类型

- 内容涉黄/赌/毒

- 内容侵权/抄袭

- 政治相关

- 涉嫌广告

- 侮辱谩骂

- 其他

详细说明

审核成功

发布时间设置

发布时间:

请选择发布时间设置

是否关联周任务-专栏模块

审核失败

失败原因

请选择失败原因

备注

请输入备注

微信扫码分享

微信扫码分享 QQ好友

QQ好友