使用大脑作为模型可以激发更强大的人工智能

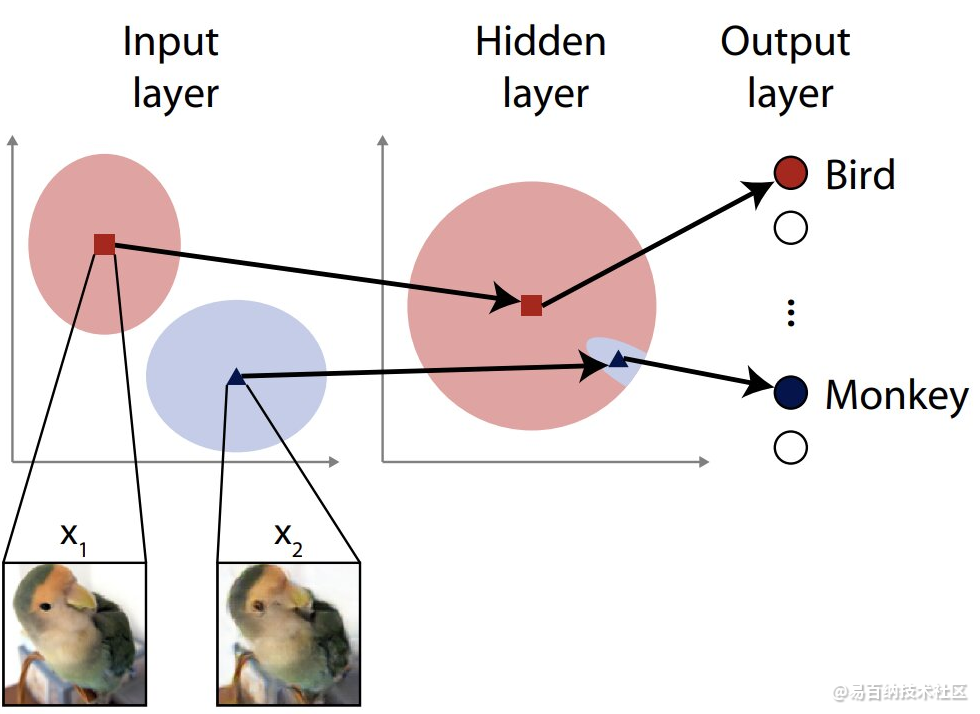

鸟还是猴子?在我们的眼中,输入图像x1和x2看起来是一样的,但隐藏的特征促使典型的神经网络错误地将这张鸟图像分类为猴子。据说图像在输入空间是远的,但在隐藏层空间是近的。研究人员的目标是关闭这个漏洞

大多数人工智能系统都是基于神经网络的,这些算法的灵感来自大脑中的生物神经元。这些网络可以由多层组成,输入来自一侧,输出来自另一侧。这些输出可以用于做出自动决策,例如在无人驾驶汽车中。

误导神经网络的攻击可能涉及利用输入层中的漏洞,但在设计防御时通常只考虑初始输入层。研究人员首次通过涉及随机噪声的过程增强了神经网络的内层,以提高其弹性。

人工智能(AI)已经成为一种相对普遍的东西;很可能你有一部带人工智能助手的智能手机,或者你使用的是由人工智能驱动的搜索引擎。虽然这是一个广义的术语,可以包括许多不同的基本处理信息的方式,有时还可以做出决策,但人工智能系统通常是使用类似于大脑的人工神经网络构建的。

和大脑一样,人工神经网络有时也会感到困惑,要么是意外,要么是第三方的故意行为。把它想象成一种视错觉——当你真的在看另一件事的时候,它可能会让你觉得你在看一件事。

然而,混淆人工神经网络的事物和可能混淆我们的事物之间的区别在于,一些视觉输入可能看起来完全正常,或者至少对我们来说可能是可以理解的,但人工神经网络可能会将其解释为完全不同的东西。

一个微不足道的例子可能是图像分类系统将猫误认为狗,但一个更严重的例子则可能是无人驾驶汽车将停车信号误认为路权标志;有医学诊断系统,以及许多其他敏感的应用程序,它们可以获取信息,为人们提供信息,甚至做出可能影响人们的决策。

由于输入不一定是可视化的,因此分析系统可能一眼就出错的原因并不总是容易的。试图破坏基于Ann的系统的攻击者可以利用这一点,巧妙地改变预期的输入模式,从而使其被误解,系统会表现错误,甚至可能出现问题。

对于这样的攻击,有一些防御技术,但它们有局限性。东京大学医学研究生院生理学系的应届毕业生Jumpei Ukita和Kenichi Ohki教授设计并测试了一种提高人工神经网络防御的新方法。

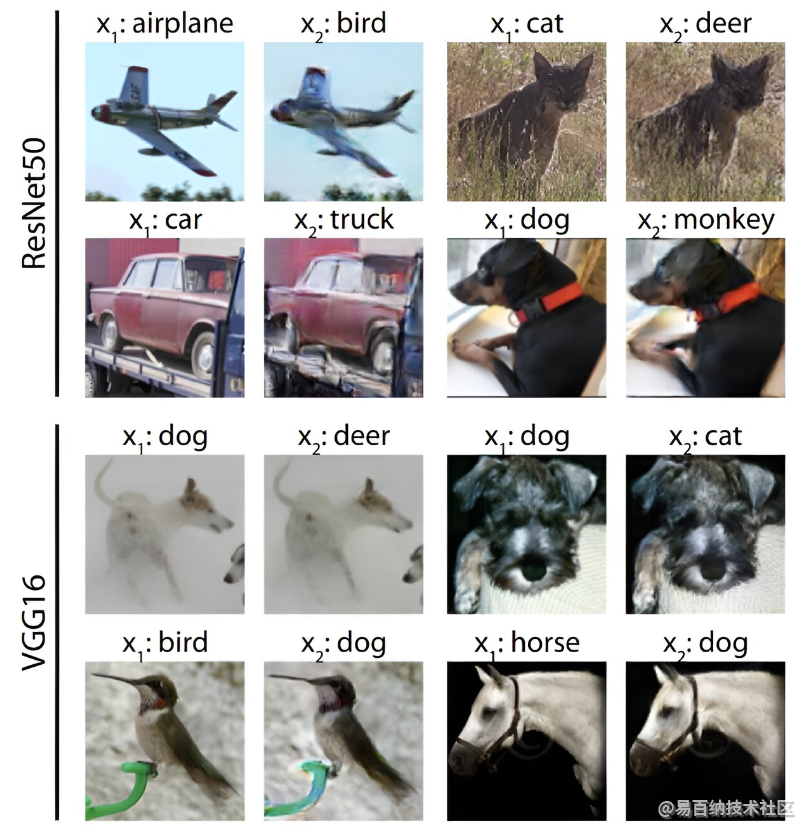

它是一只鸟吗?这是一架飞机吗?这是研究人员在运行新的防御方法之前为模拟攻击生成的图像样本。x1幅图像被正确分类,x2幅图像是欺骗未设防网络错误分类的对抗性例子

Ohki说:“神经网络通常包括虚拟神经元层。第一层通常负责通过识别与特定输入相对应的元素来分析输入。”

“攻击者可能会向图像提供伪影,诱使网络对其进行错误分类。对这种攻击的典型防御可能是故意在第一层中引入一些噪声。这听起来有违直觉,它可能会有所帮助,但通过这样做,它可以对视觉场景或其他输入集进行更大的调整。然而,这种方法并不总是那么有效,我们认为我们可以通过将目光投向输入层之外的网络内部来改进这一问题。”

Ukita和Ohki不仅仅是计算机科学家。他们还研究了人脑,这激发了他们在人工神经网络中使用他们所知道的一种现象。这不仅是为了给输入层添加噪声,也是为了给更深的层添加噪声。这通常是避免的,因为人们担心在正常情况下会影响网络的有效性。但两人发现事实并非如此,相反,噪声在他们的测试ANN中促进了更大的适应性,从而降低了其对模拟对抗性攻击的易感性。

Ukita说:“我们的第一步是设计一种假设的攻击方法,这种方法的攻击深度比输入层更深。这种攻击需要承受在输入层具有标准噪声防御的网络的弹性。我们称这些特征空间为对抗性示例。”

“这些攻击的工作原理是故意提供一个远离而不是接近人工神经网络可以正确分类的输入的输入。但诀窍是将微妙的误导性伪影呈现给更深的层。一旦我们证明了这种攻击的危险性,我们就将随机噪声注入网络的更深隐藏层,以提高它们的适应性,从而提高防御能力。我们很高兴地报告它是有效的。”

虽然这一新想法确实很强大,但该团队希望进一步开发它,使其对预期的攻击以及他们尚未测试过的其他类型的攻击更加有效。目前,防御只针对这种特定类型的攻击。

Ukita说:“未来的攻击者可能会尝试考虑能够逃脱我们在这项研究中考虑的特征空间噪声的攻击。事实上,攻击和防御是一枚硬币的两面;这是一场军备竞赛,双方都不会退缩,因此我们需要不断迭代、改进和创新新思想,以保护我们每天使用的系统。”

- 分享

- 举报

暂无数据

暂无数据-

浏览量:2341次2020-06-05 14:02:40

-

浏览量:1003次2023-08-29 09:48:16

-

浏览量:1130次2023-03-02 15:29:16

-

浏览量:1646次2022-12-06 19:29:47

-

浏览量:836次2023-08-16 09:19:16

-

浏览量:2454次2020-06-28 18:42:37

-

浏览量:1960次2024-03-19 14:18:03

-

浏览量:902次2023-08-04 10:24:56

-

浏览量:2332次2020-06-09 10:26:53

-

浏览量:4621次2017-11-02 17:07:21

-

浏览量:2439次2017-12-01 17:23:13

-

浏览量:1659次2020-04-28 10:46:56

-

浏览量:1160次2024-01-05 13:52:07

-

浏览量:5241次2021-07-30 17:02:58

-

浏览量:1078次2023-10-24 13:59:57

-

浏览量:912次2023-08-28 14:09:17

-

浏览量:3355次2017-12-25 13:30:18

-

浏览量:1765次2022-12-07 09:13:23

-

浏览量:2148次2020-04-28 09:34:43

-

广告/SPAM

-

恶意灌水

-

违规内容

-

文不对题

-

重复发帖

Debug

微信支付

微信支付举报类型

- 内容涉黄/赌/毒

- 内容侵权/抄袭

- 政治相关

- 涉嫌广告

- 侮辱谩骂

- 其他

详细说明

微信扫码分享

微信扫码分享 QQ好友

QQ好友