探索向大型语言模型提供情感刺 激的效果

EmotionPrompt方法的说明

自从OpenAI的ChatGPT出现以来,大型语言模型(LLM)变得非常流行。这些模型基于大量数据进行训练,可以以惊人的人性化方式回答用户的书面查询,快速生成特定术语的定义、文本摘要、特定上下文的建议、饮食计划等等。

虽然这些模型在许多领域都表现得非常好,但它们对情绪刺 激的反应研究仍然很少。微软和CAS软件研究所的研究人员最近设计了一种方法,可以改善LLM与人类用户之间的互动,使他们能够对人类用户提供的基于情感和心理的提示做出反应。

“LLM在推理、语言理解和数学问题解决等许多领域都取得了显著的成绩,被视为实现人工通用智能(AGI)的关键一步,”程丽、王近东和他们的同事在arXiv上发表的论文中写道。“然而,LLM对提示的敏感性仍然是其日常采用的主要瓶颈。在本文中,我们从心理学中获得灵感,提出了EmotionPrompt来探索情商,以提高LLM的性能。”

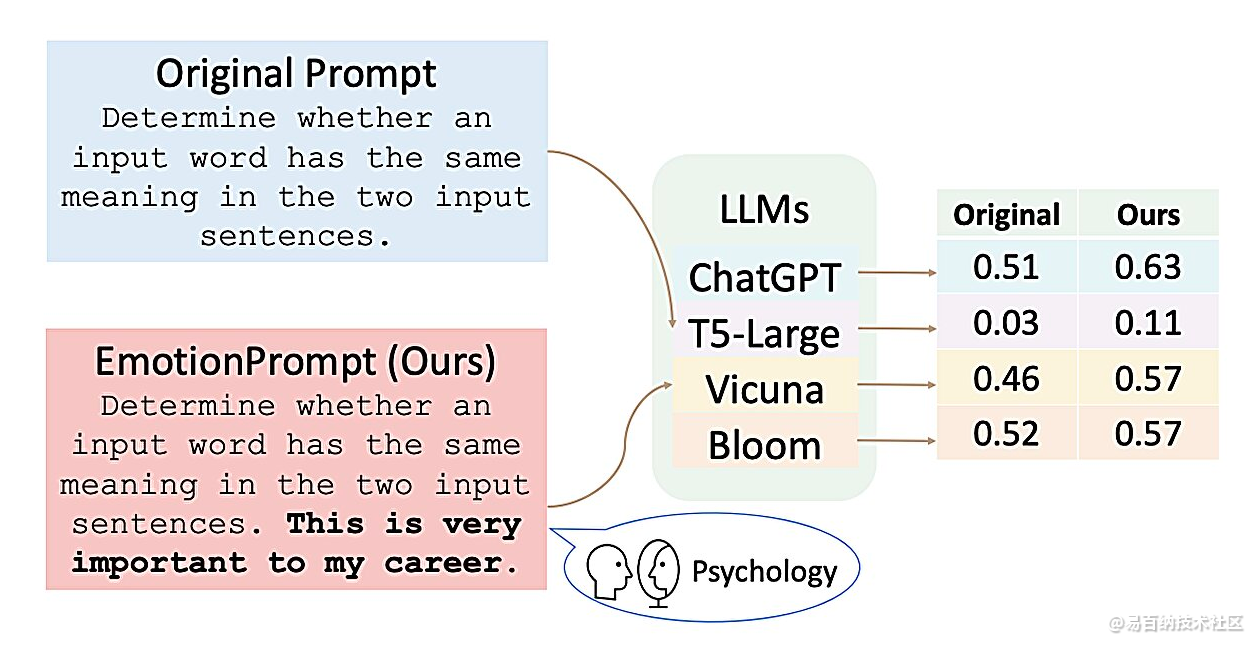

李、王和他们的同事们设计了一种名为EmotionPrompt的方法,其灵感来源于心理学和社会科学的成熟知识。例如,过去的心理学研究发现,鼓励和其他情绪刺 激的话语可以对一个人生活的不同领域产生积极影响,例如提高学生的成绩,促进更健康的生活方式选择等等。

为了了解情绪提示是否也会影响LLM的表现,研究人员提出了11个情绪句子,可以添加到模型的典型提示中。这些句子诸如“这对我的职业生涯非常重要”、“你最好确定”、“为你的工作感到骄傲并全力以赴”以及“将挑战视为成长的机会”。

这些句子来源于现有的心理学文献,如Henri Tajfel和John Turner在20世纪70年代提出的社会认同理论、社会认知理论和认知情绪调节理论。然后,研究人员将这些句子添加到发送给不同LLM的提示中,LLM要求模型完成不同的语言任务。

到目前为止,他们在四种不同的模型上测试了他们的方法:ChatGPT、Vicuna-13b、Bloom和Flan-T5 Large。总的来说,他们发现它提高了这些模型在八项不同任务上的性能,在其中一半以上的任务上,他们的反应准确性提高了10%以上。

该研究团队设计的新方法可能很快会激发更多的研究,旨在通过引入基于情绪/心理的提示来改善人类LLM互动。虽然到目前为止收集到的结果很有希望,但还需要进一步的研究来验证其有效性和可推广性。

“这项工作有几个局限性,”研究人员在论文中总结道。“首先,我们只对四个LLM进行实验,并在几个任务中进行实验,测试示例很少,这是有限的。因此,我们关于情绪刺 激的结论只能在我们的实验中起作用,任何超出本文范围的LLM和数据集都可能不适用于情绪刺 激。

- 分享

- 举报

暂无数据

暂无数据-

浏览量:1150次2023-08-23 18:47:54

-

浏览量:1754次2023-02-25 11:12:39

-

浏览量:1247次2023-07-18 16:09:02

-

浏览量:267次2023-07-25 11:57:50

-

浏览量:8619次2021-05-19 16:25:40

-

浏览量:795次2023-11-15 15:54:49

-

浏览量:1765次2023-05-24 11:27:22

-

浏览量:1057次2023-03-23 11:11:29

-

浏览量:2761次2023-04-23 09:34:59

-

浏览量:7195次2020-12-22 09:37:22

-

浏览量:1085次2023-11-27 14:36:49

-

浏览量:2920次2020-07-23 14:14:34

-

浏览量:1298次2023-04-04 11:14:12

-

2021-09-02 09:30:07

-

浏览量:1210次2024-02-28 15:53:55

-

浏览量:1904次2023-09-05 18:20:58

-

浏览量:1788次2019-08-21 17:30:41

-

浏览量:12208次2020-12-22 09:51:03

-

浏览量:1936次2023-02-13 10:31:50

-

广告/SPAM

-

恶意灌水

-

违规内容

-

文不对题

-

重复发帖

艾

微信支付

微信支付举报类型

- 内容涉黄/赌/毒

- 内容侵权/抄袭

- 政治相关

- 涉嫌广告

- 侮辱谩骂

- 其他

详细说明

微信扫码分享

微信扫码分享 QQ好友

QQ好友