资讯文章

斯坦福大学和谷歌的ResMem通过显式记忆改进了神经网络模型的泛化

当代大型神经网络在泛化新数据和新任务方面的显著成功归功于它们隐式记忆复杂训练模式的能力。增加模型大小已被证明是实现这种记忆的有效方法,但这也会极大地增加训练和服务成本。是否有一种方法可以在保持相对较小的模型规模的同时提高记忆和泛化?

斯坦福大学的一个研究团队在新论文ResMem: Learn What You Can and remember the Rest中解决了这个问题,提出了ResMem,一种剩余记忆算法,通过单独的k-nearest neighbour component执行显式记忆,提高较小神经网络模型的泛化能力。

研究小组总结了他们研究的主要贡献如下:

- 我们提出了残差记忆(ResMem),这是一种两阶段学习算法,它将基本预测模型与最近邻回归函数相结合。

- 我们通过经验证明ResMem可以提高神经网络的测试性能,特别是在训练集非常大的情况下。

- 我们从理论上分析了ResMem在程式化线性回归问题上的收敛速度,并表明它可以改进基本预测模型。

- 先前的研究表明,记忆是足够的,甚至是神经网络模型中有效泛化的必要条件。基于这一研究方向,ResMem算法通过一种新颖的显式记忆方法来提高小模型的泛化性能。

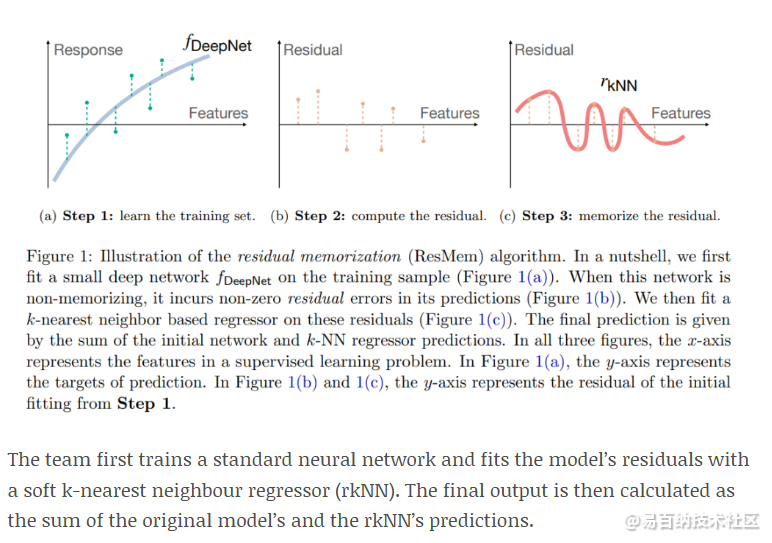

该团队首先训练了一个标准神经网络,并用软k-最近邻回归(rkNN)拟合模型的残差。最后的输出是原始模型和rkNN预测的和。

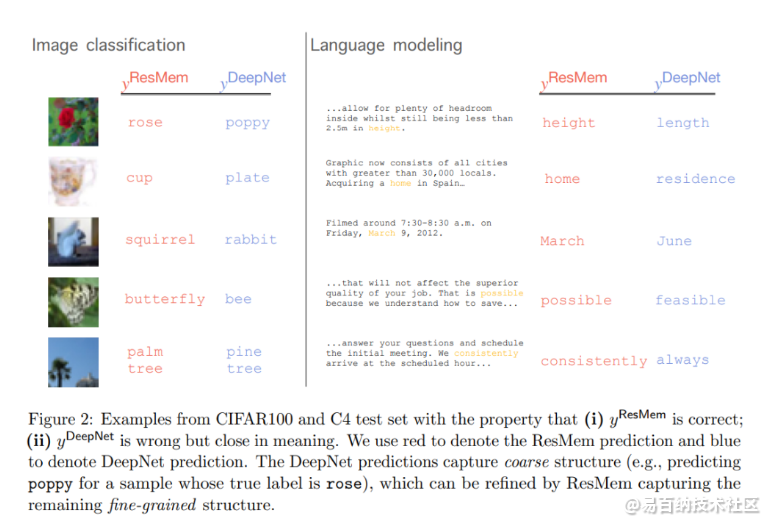

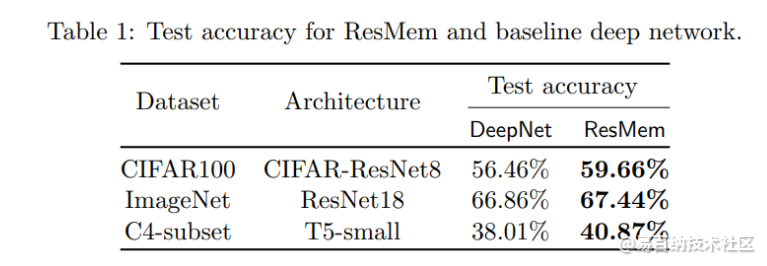

该团队的实证研究将ResMem与DeepNet的视觉基线(CIFAR100和ImageNet上的图像分类)和自然语言处理(自回归语言建模)任务进行了比较。ResMem的测试集泛化能力超过了评估中的所有基准测试。研究人员还指出,当样本数量接近无穷大时,ResMem返回的测试风险比基础预测器更有利。

声明:本文内容由易百纳平台入驻作者撰写,文章观点仅代表作者本人,不代表易百纳立场。如有内容侵权或者其他问题,请联系本站进行删除。

红包

点赞

收藏

评论

打赏

- 分享

- 举报

评论

0个

手气红包

暂无数据

暂无数据相关专栏

-

浏览量:1408次2023-02-13 11:48:11

-

浏览量:3063次2020-01-06 10:09:20

-

浏览量:4364次2021-09-04 10:17:59

-

浏览量:2239次2020-03-17 09:12:22

-

浏览量:2970次2018-01-27 13:19:46

-

2020-11-18 14:29:08

-

浏览量:6551次2021-06-07 11:48:50

-

浏览量:1668次2023-03-07 09:26:18

-

浏览量:923次2024-01-12 15:04:46

-

浏览量:1925次2020-03-19 09:24:50

-

浏览量:5129次2021-04-21 17:05:56

-

浏览量:4044次2020-10-21 09:53:48

-

浏览量:3202次2020-04-10 10:31:32

-

浏览量:8027次2021-08-11 16:51:39

-

浏览量:3554次2019-06-19 16:37:18

-

浏览量:6054次2020-11-04 09:47:48

-

浏览量:3938次2021-12-22 16:03:48

-

浏览量:2026次2018-01-20 11:56:02

-

浏览量:1007次2023-09-02 09:45:20

置顶时间设置

结束时间

删除原因

-

广告/SPAM

-

恶意灌水

-

违规内容

-

文不对题

-

重复发帖

打赏作者

艾

您的支持将鼓励我继续创作!

打赏金额:

¥1

¥5

¥10

¥50

¥100

支付方式:

微信支付

微信支付

举报反馈

举报类型

- 内容涉黄/赌/毒

- 内容侵权/抄袭

- 政治相关

- 涉嫌广告

- 侮辱谩骂

- 其他

详细说明

审核成功

发布时间设置

发布时间:

请选择发布时间设置

是否关联周任务-专栏模块

审核失败

失败原因

请选择失败原因

备注

请输入备注

微信扫码分享

微信扫码分享 QQ好友

QQ好友