【深度学习】基于Pytorch进行深度神经网络计算(一)

文章目录

1 层和块

2 自定义块

3 顺序块

4 在正向传播函数中执行代码

5 嵌套块

6 参数管理(不重要)

7 参数初始化(重要)

8 共享参数

9 我的总结- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

1 层和块

虽然你可能认为神经元、层和模型为我们的业务提供了足够的抽象,但事实证明,我们经常发现谈论比单个层大但比整个模型小的组件更方便。例如,在计算机视觉中广泛流行的ResNet-152结构就有数百层。这些层是 由层组的重复模式组成。一次只实现一层这样的网络会变得很乏味。这种问题不是我们幻想出来的,这种设计模式在实践中很常见。上面提到的ResNet结构赢得了2015年ImageNet和COCO计算机视觉比赛的识别和检测任务He.Zhang.Ren.ea.2016,目前ResNet结构仍然是许多视觉任务的首选结构。在其他的领域,如自然语言处理和语音,层以各种重复模式排列的类似结构现在也是普遍存在。

为了实现这些复杂的网络,我们引入了神经网络块的概念。块可以描述单个层、由多个层组成的组件或整个模型本身。使用块进行抽象的一个好处是可以将一些块组合成更大的组件,这一过程通常是递归的。通过定义代码来按需生成任意复杂度的块,我们可以通过简洁的代码实现复杂的神经网络。

从编程的角度来看,块由类(class)表示。它的任何子类都必须定义一个将其输入转换为输出的正向传播函数,并且必须存储任何必需的参数。注意,有些块不需要任何参数。最后,为了计算梯度,块必须具有反向传播函数。幸运的是,在定义我们自己的块时,由于自动微分提供了一些后端实现,我们只需要考虑正向传播函数和必需的参数。

下面的代码生成一个网络,其中包含一个具有256个单元和ReLU激活函数的全连接的隐藏层,然后是一个具有10个隐藏单元且不带激活函数的全连接的输出层。

import torch

from torch import nn

from torch.nn import functional as F

net = nn.Sequential(nn.Linear(20, 256), nn.ReLU(), nn.Linear(256, 10))

X = torch.rand(2, 20)

net(X)- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

tensor([[ 0.1401, 0.0838, 0.0563, 0.2587, 0.0227, 0.0446, 0.0525, 0.3072,

-0.0298, -0.1346],

[ 0.1869, 0.2070, -0.0762, 0.2382, 0.0845, 0.0559, 0.1689, 0.1760,

-0.0364, -0.0506]], grad_fn=

我们通过实例化nn.Sequential来构建我们的模型,层的执行顺序是作为参数传递的。简而言之,(nn.Sequential定义了一种特殊的Module),即在PyTorch中表示一个块的类。它维护了一个由Module组成的有序列表,注意,两个全连接层都是Linear类的实例,Linear类本身就是Module的子类。正向传播(forward)函数也非常简单:它将列表中的每个块连接在一起,将每个块的输出作为下一个块的输入。注意,到目前为止,我们一直在通过net(X)调用我们的模型来获得模型的输出。这实际上是net.__call__(X)的简写。

2 自定义块

- 将输入数据作为其正向传播函数的参数。

- 通过正向传播函数来生成输出。请注意,输出的形状可能与输入的形状不同。例如,我们上面模型中的第一个全连接的层接收任意维的输入,但是返回一个维度256的输出。

- 计算其输出关于输入的梯度,可通过其反向传播函数进行访问。通常这是自动发生的。

- 存储和访问正向传播计算所需的参数。

- 根据需要初始化模型参数。

在下面的代码片段中,我们从零开始编写一个块。它包含一个多层感知机,其具有256个隐藏单元的隐藏层和一个10维输出层。注意,下面的MLP类继承了表示块的类。我们的实现将严重依赖父类,只需要提供我们自己的构造函数(Python中的__init__函数)和正向传播函数。

def forward(self, X):定义模型的正向传播,即如何根据输入X返回所需的模型输出。

class MLP(nn.Module):

# 用模型参数声明层。这里,我们声明两个全连接的层

def __init__(self):

# 调用`MLP`的父类`Block`的构造函数来执行必要的初始化。

# 这样,在类实例化时也可以指定其他函数参数,例如模型参数`params`(稍后将介绍)

super().__init__()

self.hidden = nn.Linear(20, 256) # 隐藏层

self.out = nn.Linear(256, 10) # 输出层

def forward(self, X):

# 注意,这里我们使用ReLU的函数版本,其在nn.functional模块中定义。

return self.out(F.relu(self.hidden(X)))- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

让我们首先关注正向传播函数。注意,它以X作为输入,计算带有激活函数的隐藏表示,并输出其未归一化的输出值。在这个MLP实现中,两个层都是实例变量。要了解这为什么是合理的,可以想象实例化两个多层感知机(net1和net2),并根据不同的数据对它们进行训练。当然,我们希望它们学到两种不同的模型。

我们在构造函数中[实例化多层感知机的层,然后在每次调用正向传播函数时调用这些层]。注意一些关键细节。首先,我们定制的__init__函数通过super().__init__()调用父类的__init__函数,省去了重复编写适用于大多数块的模版代码的痛苦。然后我们实例化两个全连接层,分别为self.hidden和self.out。注意,除非我们实现一个新的运算符,否则我们不必担心反向传播函数或参数初始化,系统将自动生成这些。让我们试一下。

net = MLP()

net(X)- 1

- 2

tensor([[-0.0973, -0.0821, 0.1170, -0.2313, 0.0252, -0.1992, -0.2581, -0.0856,

-0.2045, -0.0475],

[-0.0532, 0.0742, 0.1066, -0.3467, -0.1418, -0.2308, -0.1956, 0.0962,

-0.1529, -0.1718]], grad_fn=

3 顺序块

现在我们可以更仔细地看看Sequential类是如何工作的。回想一下Sequential的设计是为了把其他模块串起来。为了构建我们自己的简化的MySequential,我们只需要定义两个关键函数:

- 一种将块逐个追加到列表中的函数。

- 一种正向传播函数,用于将输入按追加块的顺序传递给块组成的“链条”。

下面的MySequential类提供了与默认Sequential类相同的功能。

class MySequential(nn.Module):

def __init__(self, *args):

super().__init__()

for block in args:

# 这里,`block`是`Module`子类的一个实例。我们把它保存在'Module'类的成员变量

# `_modules` 中。`block`的类型是OrderedDict。

self._modules[block] = block

def forward(self, X):

# OrderedDict保证了按照成员添加的顺序遍历它们

for block in self._modules.values():

X = block(X)

return X- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

net = MySequential(nn.Linear(20, 256), nn.ReLU(), nn.Linear(256, 10))

net(X)- 1

- 2

tensor([[-0.0215, -0.0739, 0.0098, -0.1507, -0.3953, -0.1001, -0.0858, -0.0976,

0.0401, 0.0850],

[-0.0207, 0.0164, 0.0923, -0.1889, -0.4095, -0.1132, -0.1467, -0.0525,

0.0488, 0.0115]], grad_fn=

4 在正向传播函数中执行代码

Sequential类使模型构造变得简单,允许我们组合新的结构,而不必定义自己的类。然而,并不是所有的架构都是简单的顺序结构。当需要更大的灵活性时,我们需要定义自己的块。例如,我们可能希望在正向传播函数中执行Python的控制流。此外,我们可能希望执行任意的数学运算,而不是简单地依赖预定义的神经网络层。

你可能已经注意到,到目前为止,我们网络中的所有操作都对网络的激活值及网络的参数起作用。然而,有时我们可能希望合并既不是上一层的结果也不是可更新参数的项。我们称之为常数参数(constant parameters)。例如,我们需要一个计算函数$f(\mathbf{x},\mathbf{w}) = c \cdot \mathbf{w}^\top \mathbf{x}$的层,其中$\mathbf{x}$是输入,$\mathbf{w}$是我们的参数,$c$是某个在优化过程中没有更新的指定常量。因此我们实现了一个FixedHiddenMLP类,如下所示。

class FixedHiddenMLP(nn.Module):

def __init__(self):

super().__init__()

# 不计算梯度的随机权重参数。因此其在训练期间保持不变。

self.rand_weight = torch.rand((20, 20), requires_grad=False)

self.linear = nn.Linear(20, 20)

def forward(self, X):

X = self.linear(X)

# 使用创建的常量参数以及`relu`和`dot`函数。

X = F.relu(torch.mm(X, self.rand_weight) + 1)

# 复用全连接层。这相当于两个全连接层共享参数。

X = self.linear(X)

# 控制流

while X.abs().sum() > 1:

X /= 2

return X.sum()- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

在这个FixedHiddenMLP模型中,我们实现了一个隐藏层,其权重(self.rand_weight)在实例化时被随机初始化,之后为常量。这个权重不是一个模型参数,因此它永远不会被反向传播更新,然后,网络将这个固定层的输出通过一个全连接层。

注意,在返回输出之前,我们的模型做了一些不寻常的事情。我们运行了一个while循环,在$L_1$范数大于$1$的条件下,将输出向量除以$2$,直到它满足条件为止。最后,我们返回了X中所有项的和。据我们所知,没有标准的神经网络执行这种操作。注意,此特定操作在任何实际任务中可能都没有用处。只是向你展示如何将任意代码集成到神经网络计算的流程中。

5 嵌套块

[混合搭配各种组合块的方法]。在下面的例子中,我们以一些想到的方法嵌套块。

class NestMLP(nn.Module):

def __init__(self):

super().__init__()

self.net = nn.Sequential(nn.Linear(20, 64), nn.ReLU(),

nn.Linear(64, 32), nn.ReLU())

self.linear = nn.Linear(32, 16)

def forward(self, X):

return self.linear(self.net(X))

chimera = nn.Sequential(NestMLP(), nn.Linear(16, 20), FixedHiddenMLP())

chimera(X)- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

chimera = nn.Sequential(NestMLP(), nn.Linear(16, 20), FixedHiddenMLP())完成了嵌套哦!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!!

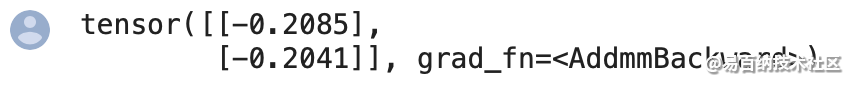

6 参数管理(不重要)

介绍以下内容:

访问参数,用于调试、诊断和可视化。

参数初始化。

在不同模型组件间共享参数。

import torch

from torch import nn

net = nn.Sequential(nn.Linear(4, 8), nn.ReLU(), nn.Linear(8, 1))

X = torch.rand(size=(2, 4))

net(X)- 1

- 2

- 3

- 4

- 5

- 6

我们从已有模型中访问参数。当通过Sequential类定义模型时,我们可以通过索引来访问模型的任意层。这就像模型是一个列表一样。每层的参数都在其属性中。如下所示,我们可以检查第二个全连接层的参数。

print(net[2].state_dict())- 1

[目标参数]

注意,每个参数都表示为参数(parameter)类的一个实例。要对参数执行任何操作,首先我们需要访问底层的数值。有几种方法可以做到这一点。有些比较简单,而另一些则比较通用。下面的代码从第二个神经网络层提取偏置,提取后返回的是一个参数类实例,并进一步访问该参数的值。

print(type(net[2].bias))

print(net[2].bias)

print(net[2].bias.data)- 1

- 2

- 3

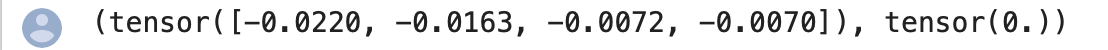

7 参数初始化(重要)

调用内置的初始化器。下面的代码将所有权重参数初始化为标准差为0.01的高斯随机变量,且将偏置参数设置为0。

def init_normal(m):

if type(m) == nn.Linear:

nn.init.normal_(m.weight, mean=0, std=0.01)

nn.init.zeros_(m.bias)

net.apply(init_normal)

net[0].weight.data[0], net[0].bias.data[0]- 1

- 2

- 3

- 4

- 5

- 6

我们还可以将所有参数初始化为给定的常数(比如1)。

def init_constant(m):

if type(m) == nn.Linear:

nn.init.constant_(m.weight, 1)

nn.init.zeros_(m.bias)

net.apply(init_constant)

net[0].weight.data[0], net[0].bias.data[0]- 1

- 2

- 3

- 4

- 5

- 6

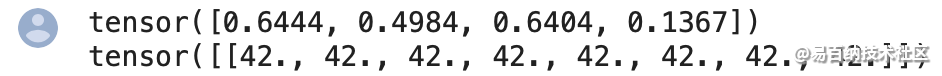

我们还可以[对某些块应用不同的初始化方法]。例如,下面我们使用Xavier初始化方法初始化第一层,然后第二层初始化为常量值42。

def xavier(m):

if type(m) == nn.Linear:

nn.init.xavier_uniform_(m.weight)

def init_42(m):

if type(m) == nn.Linear:

nn.init.constant_(m.weight, 42)

net[0].apply(xavier)

net[2].apply(init_42)

print(net[0].weight.data[0])

print(net[2].weight.data)- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

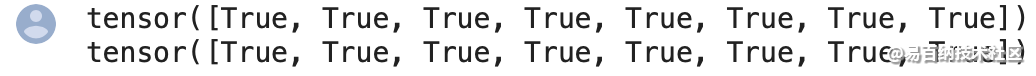

8 共享参数

我们看看如何优雅地做这件事。在下面,我们定义一个稠密层,然后使用它的参数来设置另一个层的参数。

# 我们需要给共享层一个名称,以便可以引用它的参数。

shared = nn.Linear(8, 8)

net = nn.Sequential(nn.Linear(4, 8), nn.ReLU(),

shared, nn.ReLU(),

shared, nn.ReLU(),

nn.Linear(8, 1))

net(X)

# 检查参数是否相同

print(net[2].weight.data[0] == net[4].weight.data[0])

net[2].weight.data[0, 0] = 100

# 确保它们实际上是同一个对象,而不只是有相同的值。

print(net[2].weight.data[0] == net[4].weight.data[0])- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

这个例子表明第二层和第三层的参数是绑定的。它们不仅值相等,而且由相同的张量表示。因此,如果我们改变其中一个参数,另一个参数也会改变。你可能会想,当参数绑定时,梯度会发生什么情况?答案是由于模型参数包含梯度,因此在反向传播期间第二个隐藏层和第三个隐藏层的梯度会加在一起。

9 我的总结

在很多神经网络中,往往会出现多个层共享一个权重的情况,pytorch可以快速地处理权重共享问题。

例子1:

class ConvNet(nn.Module):

def init(self):

super(ConvNet, self).init()

self.conv_weight = nn.Parameter(torch.randn(3, 3, 5, 5))

def forward(self, x):

x = nn.functional.conv2d(x, self.conv_weight, bias=None, stride=1, padding=2, dilation=1, groups=1)

x = nn.functional.conv2d(x, self.conv_weight.transpose(2, 3).contiguous(), bias=None, stride=1, padding=0, dilation=1,

groups=1)

return x

上边这段程序定义了两个卷积层,这两个卷积层共享一个权重conv_weight,第一个卷积层的权重是conv_weight本身,第二个卷积层是conv_weight的转置。注意在gpu上运行时,transpose()后边必须加上.contiguous()使转置操作连续化,否则会报错。

例子2:

class LinearNet(nn.Module):

def init(self):

super(LinearNet, self).init()

self.linear_weight = nn.Parameter(torch.randn(3, 3))

def forward(self, x):

x = nn.functional.linear(x, self.linear_weight)

x = nn.functional.linear(x, self.linear_weight.t())

return x

这个网络实现了一个双层感知器,权重同样是一个parameter的本身及其转置。

例子3:

class LinearNet2(nn.Module):

def init(self):

super(LinearNet2, self).init()

self.w = nn.Parameter(torch.FloatTensor([[1.1,0,0], [0,1,0], [0,0,1]]))

def forward(self, x):

x = x.mm(self.w)

x = x.mm(self.w.t())

return x

就到这啦。

- 分享

- 举报

暂无数据

暂无数据-

浏览量:8546次2021-05-28 16:59:43

-

浏览量:6657次2021-05-31 17:02:05

-

浏览量:5572次2021-05-28 16:59:25

-

浏览量:5051次2021-07-26 11:28:05

-

浏览量:841次2024-02-01 14:28:23

-

浏览量:4026次2018-02-14 10:30:11

-

浏览量:4978次2021-04-23 14:09:37

-

浏览量:1102次2024-02-06 11:41:16

-

浏览量:494次2023-09-28 11:44:09

-

浏览量:4701次2021-04-20 15:50:27

-

浏览量:16462次2021-06-07 17:47:54

-

浏览量:7200次2021-07-26 11:30:25

-

浏览量:548次2024-02-01 14:20:47

-

浏览量:4480次2021-04-23 14:09:15

-

2023-07-05 10:13:58

-

浏览量:528次2023-08-28 09:56:42

-

浏览量:4337次2021-04-19 14:54:23

-

浏览量:6340次2021-07-14 09:51:09

-

浏览量:781次2023-09-06 11:12:55

-

广告/SPAM

-

恶意灌水

-

违规内容

-

文不对题

-

重复发帖

这把我C

微信支付

微信支付举报类型

- 内容涉黄/赌/毒

- 内容侵权/抄袭

- 政治相关

- 涉嫌广告

- 侮辱谩骂

- 其他

详细说明

微信扫码分享

微信扫码分享 QQ好友

QQ好友