【深度学习】面向医学图像的病灶分割调研(二)

【深度学习】面向医学图像的病灶分割调研(二)

文章目录

3 论文分析

3.1《nnU-Net for Brain Tumor Segmentation》

3.2《An attempt at beating the 3D U-Net》

3.3《TransBTS: Multimodal Brain Tumor Segmentation Using Transformer》

参考- 1

- 2

- 3

- 4

- 5

- 6

3 论文分析

3.1《nnU-Net for Brain Tumor Segmentation》

论文背景与研究动机

脑肿瘤分割被认为是医学领域中最困难的分割问题之一。同时,通过支持诊断,治疗计划和治疗反应监测[4],精确肿瘤定位的应用可以显著提高护理质量。此外,脑肿瘤和相关亚区域的分割允许识别新的成像生物标志物,这反过来又可以实现更精确和可靠的疾病分层[5]和预测[6]。

论文实现方式

论文将将nnU-Net应用于BraTS 2020挑战赛的细分任务。未经修改的nnU-Net基准配置已经取得了可观的结果。通过合并有关BraTS的特定修改,这些修改涉及后处理、训练方式、更具综合性的数据扩充以及对nnU-Net管道的一些较小修改,论文能够大幅提高其分割性能。此外,论文还重新实施了BraTS排名方案,以确定哪种nnU-Net变体最适合它所强加的要求。论文中的方法在BraTS 2020竞赛中名列第一,全肿瘤,肿瘤核心和增强肿瘤的Dice评分分别为88.95、85.06和82.03,HD95值为8.498、17.337和17.805。

nnUNet浓缩了医学图像的语义分割领域的大部分知识,并且具备自动为不同任务设计不同训练方案的框架,不需要人工进行调参。自动对不同的数据属性(图片质量、图片模态、图片大小、体素大小、类别比率等)进行分析,生成独一无二的数据指纹,表示数据集的关键属性。制定独一无二的训练方案管道指纹,采用2D、3D和3D_Cascaded三个网络分别训练,得出各自的模型(五折交叉验证),选择出最优的模型进行推理。

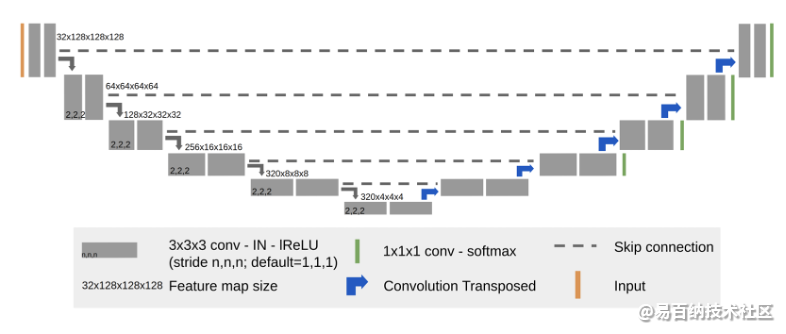

论文提出的方法基于nnU-Net,BraTS分割的目标有三类:Enhancing tumor、Tumor core和Whole tumor,然而在计算这几类分割指标的时候区域是有重叠的,通常的多分类网络再最后通过Softmax直接预测出不同的三个类别,为了使得网络在训练过程中预测的脑肿瘤区域跟实际计算指标时的脑肿瘤区域相一致,Fabian等人把Softmax换成了多个Sigmoid分支,每一支对应一个不同的脑肿瘤区域。在后处理工作中主要针对Enhancing tumor,根据BraTS的评分规则,如果一个病例Ground truth里没有Enhancing tumor,而预测出来的结果里有,DSC=0,反之DSC=1。因此Enhancing tumor的False positive对平均的得分影响较大。针对这个问题,后处理过程中把所占空间低于某个阈值的Enhancing tumor去掉,阈值通过交叉验证来得到。此外,Dice loss采用基于批次的方式计算。如图3-5所示,为nnU-Net框架最终选择的网络结构。

图3-5 nnU-Net框架生成的网络体系结构

论文总结

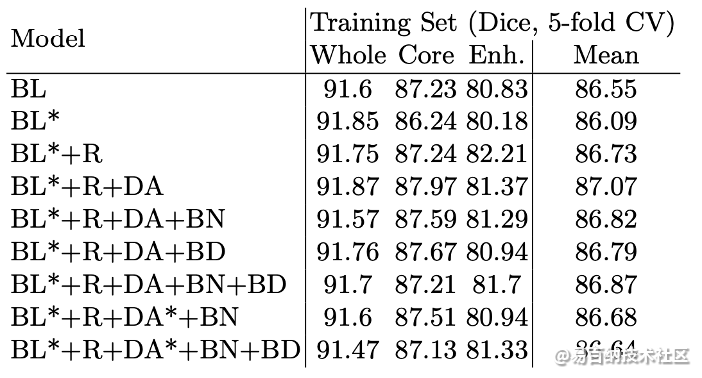

论文针对脑肿瘤分割问题选择了nnU-Net框架,并对其做了一些改进,取得了很好的病灶区域分割效果,基于nnU-Net框架的通用性,我认为论文提出的方法可以应用在更多医学图像分割任务上。训练集五折交叉实验结果如表3-3所示,比较前两行结果:增大batch size到5(BL*)后Mean DSC并没有提升,默认batch size为2时的结果更优。

表3-3 训练集五折交叉实验结果

验证集分割结果如表3-4所示,Enhancing tumor的HD95要比Whole tumor 和Tumor core大很多。

表3-4 验证集分割结果

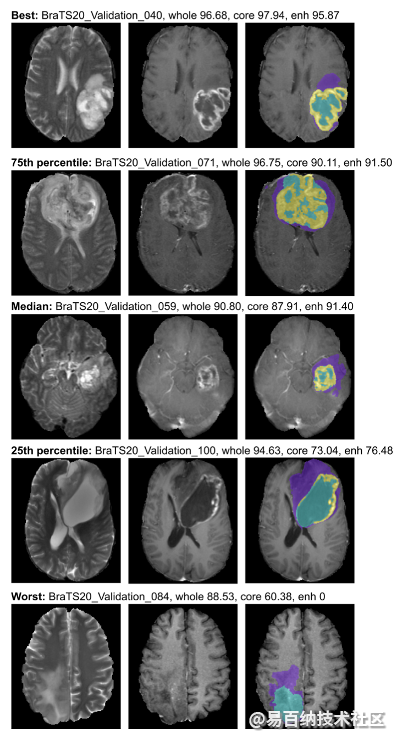

更多的分割结果如图3-6所示,包括不同程度肿瘤的分割情况。

图3-6 验证集分割结果定性分析

3.2《An attempt at beating the 3D U-Net》

论文背景与研究动机

SZ肿瘤每年超过40万例,是一个严重的健康问题。目前,手术是最常见的治疗方法。对SZ和肿瘤组织进行语义分割具有现实意义。论文中的主要任务是从SZCT图像中分割出SZ和S肿瘤。

论文实现方式

论文中提到的预处理方法包括重采样和强度裁剪,目的是使得KiTS数据集的图像强度值范围更易被CNN处理。网络结构如图3-7所示,基于3D U-Net做了很小的改动,可以理解为3D U-Net 和Residual Block (V-Net)的结合。

图3-7 3D U-Net的改进网络结构

论文总结

对于分割任务,除了网络架构,特别设计的预处理方法也非常重要。

该篇沦为在竞赛中取得的效果如表3-5所示。

表3-5 KiTS数据集上的消融实验

3.3《TransBTS: Multimodal Brain Tumor Segmentation Using Transformer》

论文背景与研究动机

Transformer可以从使用自注意力机制进行全局信息建模中受益,近来来已经在自然语言处理和2D图像分类方面取得了成功。然而,局部和全局特征对于密集的预测任务都至关重要,特别是3D医学图像分割任务。3D图像分割即关注局部也关注全局,这就是论文研究的出发点,即不仅仅需要Transformer这种全局信息,同时也需要得到CNN那种的局部信息,所以进行了改进。论文首次探索了将3DCNN中的Transformer进行MRI的脑部肿瘤分割,提出了一个基于编码和解码结构的新网络TransBTS。

论文实现方式

为了捕获局部的3D上下文信息,编码器首先使用3DCNN来提取三维空间特征图。解码器利用Transformer嵌入的特征并执行渐进式上采样以预测详细的分割图。下图3-8给出了所提出的TransBTS结构,

图3-8 TransBTS的总体架构

首先对MRI图像数据切片,使用3D CNN来生成紧凑的特征图捕获空间和深度信息,然后利用Transformer编码器在全局空间中建立长距离依赖模型。最后对上采样层和卷积层进行多次叠加,逐步得到高分辨率的分割结果。

论文总结

TransUNet[7]是一个2D网络 ,以切片的方式处理每个3D医学图像。但是,论文中的TransBTS是基于3DCNN并一次处理所有图像切片,从而可以更好的利用切片之间的连续信息。即TransUNet仅仅关注标记化图像块之间的空间相关性,但是论文中的方法同时可以对切片/深度维度和空间维度中的长程依赖关系进行建模,以实现三维分割。由于TransUNet采用了ViT结构,因此它依赖于大规模图像数据集上预训练的ViT模型,相比之下,论文提出的TransBTS具有灵活的网络设计,并且在任务特定的数据集上从头开始训练,而无需依赖预训练的权重。

论文首先在BraTS 2019训练集上进行五折交叉验证评估, TransBTS实现在ET,WT,TC的平均Dice系数分数为78.92%,90.23%,81.19%,同时在BraTS2019验证集上进行了实验,比较了TransBTS与现有最先进的3D方法,量化结果如表3-6。

表3-6 在BraTS 2019验证集上的分割评价结果比较

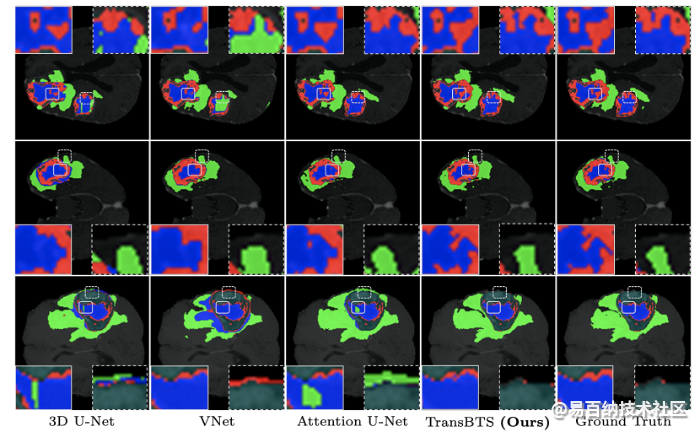

对于定性分析,论文还显示出各种方法的脑肿瘤分割结果的视觉比较,包括3D U-Net,V-Net,和TransBTS等。从图3-9可以看出,TransBTS可以更准确的描述脑肿瘤,通过在每个体积之间建模的长距离依赖性来更准确地描述脑肿瘤,并产生更好地分割掩膜。

图3-9 基于Transformer的多模态脑肿瘤分割

参考

[1]. Seo H, Huang C, Bassenne M, et al. Modified U-Net (mU-Net) with incorporation of object-dependent high level features for improved liver and liver-tumor segmentation in CT images[J]. IEEE transactions on medical imaging, 2019, 39(5): 1316-1325.

[2]. Isensee F, Maier-Hein K H. nnU-Net for Brain Tumor Segmentation[C]//Brainlesion: Glioma, Multiple Sclerosis, Stroke and Traumatic Brain Injuries: 6th International Workshop, BrainLes 2020, Held in Conjunction with MICCAI 2020, Lima, Peru, October 4, 2020, Revised Selected Papers, Part II. Springer Nature, 2021, 12658: 118.

[3]. Isensee F, Maier-Hein K H. An attempt at beating the 3D U-Net[J]. arXiv preprint arXiv:1908.02182, 2019.

[4]. Wang W, Chen C, Ding M, et al. TransBTS: Multimodal Brain Tumor Segmentation Using Transformer[J]. arXiv preprint arXiv:2103.04430, 2021.

[5]. Haralick RM, Shapiro LG. Computer and Robot Vision[M]. Addison-Wesley. 1992:100-110.

[6]. REN S, GIRSHICK R, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Trans Pattern Anal Mach Intell, 2017, 39(6): 1137-1149.

[7]. REN S, HE K, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[C]//International Conference on Neural Information Processing Systems. Cambridge, Massachusetts: MIT Press, 2015: 91-99.

[8]. P. Kickingereder, F. Isensee, I. Tursunova, J. Petersen, U. Neuberger, D. Bonekamp, G. Brugnara, M. Schell, T. Kessler, M. Foltyn et al., “Automated quantitative tumour response assessment of mri in neuro-oncology with artificial neural networks: a multicentre, retrospective study,” The Lancet Oncology, vol. 20, no. 5, pp. 728–740, 2019.

[9]. P. Kickingereder, U. Neuberger, D. Bonekamp, P. L. Piechotta, M. Go ̈tz, A. Wick, M. Sill, A. Kratz, R. T. Shinohara, D. T. Jones et al., “Radiomic subtyping im- proves disease stratification beyond key molecular, clinical, and standard imaging characteristics in patients with glioblastoma,” Neuro-oncology, vol. 20, no. 6, pp. 848–857, 2018.

[10]. P. Kickingereder, M. Go ̈tz, J. Muschelli, A. Wick, U. Neuberger, R. T. Shinohara, M. Sill, M. Nowosielski, H.-P. Schlemmer, A. Radbruch et al., “Large-scale radiomic profiling of recurrent glioblastoma identifies an imaging predictor for stratifying anti-angiogenic treatment response,” Clinical Cancer Research, vol. 22, no. 23, pp. 5765–5771, 2016.

[11]. Chen J, Lu Y, Yu Q, et al. Transunet: Transformers make strong encoders for medical image segmentation[J]. arXiv preprint arXiv:2102.04306, 2021.

[12]. Kwak S, Hong S, Han B. Weakly supervised semantic segmentation using superpixel pooling network[C]//Proceedings of the AAAI Conference on Artificial Intelligence. 2017, 31(1).

[13]. Cao H, Wang Y, Chen J, et al. Swin-Unet: Unet-like Pure Transformer for Medical Image Segmentation[J]. arXiv preprint arXiv:2105.05537, 2021.

- 分享

- 举报

暂无数据

暂无数据-

浏览量:7559次2021-07-19 17:08:40

-

浏览量:7438次2021-07-19 17:10:27

-

浏览量:6639次2021-06-07 09:26:53

-

浏览量:13473次2021-07-05 09:47:30

-

浏览量:157次2023-08-30 15:28:02

-

浏览量:13047次2021-05-11 15:08:10

-

浏览量:9291次2021-06-21 11:49:58

-

浏览量:15938次2021-07-29 10:22:10

-

浏览量:14424次2021-05-04 20:16:03

-

浏览量:6833次2021-05-04 20:17:10

-

浏览量:16227次2021-04-28 16:21:52

-

浏览量:15727次2021-05-31 17:01:00

-

浏览量:7354次2021-04-29 12:46:50

-

浏览量:6922次2021-04-08 11:11:30

-

浏览量:11156次2021-06-25 15:00:55

-

浏览量:30251次2021-05-04 20:18:49

-

浏览量:1628次2023-02-14 14:48:11

-

浏览量:13520次2021-07-08 09:43:47

-

浏览量:104次2023-08-30 20:18:28

-

广告/SPAM

-

恶意灌水

-

违规内容

-

文不对题

-

重复发帖

这把我C

微信支付

微信支付举报类型

- 内容涉黄/赌/毒

- 内容侵权/抄袭

- 政治相关

- 涉嫌广告

- 侮辱谩骂

- 其他

详细说明

微信扫码分享

微信扫码分享 QQ好友

QQ好友